Технологический институт Массачусетса (MIT) запустил интернет-проект под названием Moral Machine. Это сайт с набором тестов, которые должны помочь ученым разобраться с тем, как искусственный интеллект должен совершать моральный выбор.

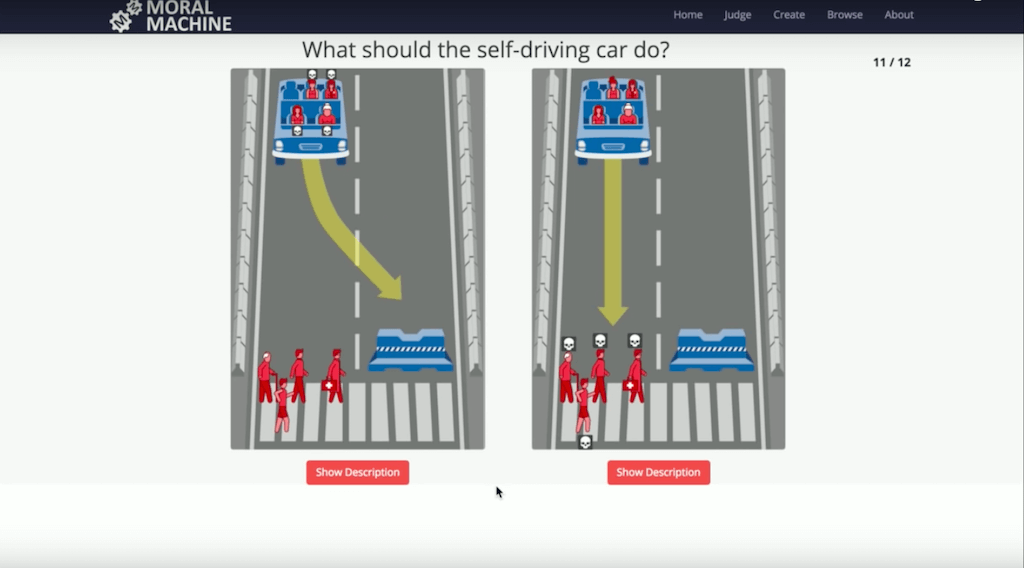

Moral Machine предлагает всем желающим пройти тест на моральную дилемму. Если машина на автопилоте попадает в ситуацию, когда неминуемо кто-то должен погибнуть – пассажиры или пешеходы, какой выбор она должна сделать? Как из двух зол выбрать меньшее – убить двух пассажиров или пять пешеходов? Как внешний наблюдатель, пользователь должен оценить, какое решение является более приемлемым. После прохождения теста можно сравнить свой ответ с ответами других людей.

Запуску сайта предшествовало исследование MIT, в котором ученые пытались решить проблему, на какое поведение нужно программировать автопилот при подобных экстренных ситуациях. Опрошенные для исследования люди выявили неоднозначную оценку действий автопилота.

Респонденты одобряли выбор машины, которая уходила от столкновения с пешеходами и жертвовала пассажирами, но сами не готовы были оказаться в роли пожертвованных пассажиров.

Этим летом произошло первое ДТП с летальным исходом с участием машины на автопилоте.